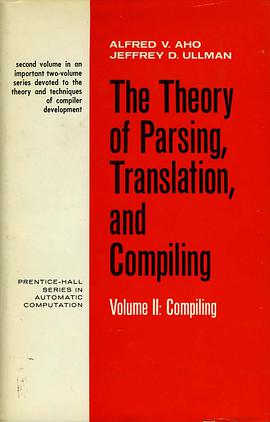

The Theory of Parsing, Translation, and Compiling pdf epub mobi txt 电子书 下载 2026

- Compiler

- Parsing

- Translation

- Formal Languages

- Automata Theory

- Programming Languages

- Computer Science

- Algorithms

- Syntax Analysis

- Semantic Analysis

具体描述

作者简介

目录信息

读后感

评分

评分

评分

评分

用户评价

这本书的封面设计简洁得令人印象深刻,那种古朴的字体搭配米白色的纸张,立刻让人感受到一种学术的厚重感。初次翻开,我被其精密的逻辑结构所吸引,作者显然对形式语言理论有着极其深刻的理解,每一个章节的过渡都如同数学证明般严谨而流畅。我特别欣赏它在引言部分对“可计算性”核心概念的阐述,那种深入浅出的方式,使得即便是初次接触编译原理的读者也能迅速把握住问题的本质。全书的论证过程层层递进,从最基础的文法定义开始,逐步构建起一个完整的分析与翻译框架。阅读过程中,我时常会停下来,回味那些巧妙的例子,它们完美地印证了理论的有效性。这本书与其说是一本教科书,不如说是一份详尽的路线图,指引着我们如何从抽象的语言描述走向实际的机器执行,那种满足感是难以言喻的。它的深度,要求读者必须投入足够的时间和精力,但回报是巨大的,它为你打下了一个坚不可摧的理论基石。

评分这本书的魅力在于其跨越时代的视角。虽然编译理论的发展日新月异,但作者对核心计算模型的坚持和阐释,展现了永恒的价值。我特别关注了它对“翻译”过程的哲学思考,它不仅仅是将一种符号系统映射到另一种,更是一种对信息结构重组的深刻理解。书的后半部分对代码优化策略的探讨,虽然没有涉及最新的即时编译(JIT)技术,但它对数据流分析和控制流图构建的经典描述,依然是理解现代编译器优化的基石。阅读这些章节时,我仿佛在与编译器领域的先驱进行跨时空的对话,感受他们当年是如何一步步攻克这些基础难题的。这种历史的厚度和理论的深度相结合,使得这本书不仅仅是技术手册,更像是一部计算科学的史诗。

评分我必须承认,这本书的阅读门槛相当高,它不是那种可以轻松放在咖啡桌上消磨时间的读物。它的语言风格极其凝练,几乎没有多余的修饰,每一个句子都承载着密集的专业信息。对于初学者来说,可能需要搭配大量的外部资源辅助理解,因为作者默认读者已经具备了扎实的离散数学和抽象代数背景。但对于已经有一定基础的读者而言,这种高效的表达方式无疑是最高效的学习途径。我尤其欣赏其在形式语义学部分的处理,它没有陷入无谓的哲学争论,而是直接给出了操作语义和公理语义的对比分析,这种务实的态度在理论书籍中非常罕见。合上书本时,我感觉我的思维逻辑仿佛被重新校准了一遍,变得更加精确和系统化,这是一种知识的内化过程,远超一般的阅读收获。

评分这本书的排版和装帧质量堪称业界典范。通常技术书籍在图文混排时容易出现字体大小不一、公式对齐混乱的问题,但这本书在这方面做得无可挑剔,即使是复杂的希腊字母和下标也能保持完美的视觉平衡。影响我阅读体验的是其案例选择。虽然理论非常完美,但部分示例代码(如果书中包含的话)显得略微陈旧,未能完全反映现代面向对象语言的特性。不过,这或许是好事,因为它迫使我必须将这些经典的算法思想“翻译”到我日常使用的语言环境中,这本身就是一种高级的思维练习。这种挑战性反而激发了我的学习热情,让我不再满足于调用库函数,而是想弄清楚每一个字节是如何被精确操控的。最终,这本书给予我的,是一种掌控感,一种对程序生命周期从诞生到执行全过程的清晰掌控。

评分这本书的阅读体验,对于我这样一个在业界摸爬滚打多年的工程师来说,更像是一次对自身知识体系的“回炉重塑”。我原以为自己对某些底层机制已经了如指掌,但在阅读到关于LL(k)分析器优化和上下文相关文法的处理章节时,才发现自己以往的理解存在诸多盲区。作者在处理歧义消除和错误恢复的章节时,展现了惊人的洞察力。他没有满足于简单的理论介绍,而是深入探讨了在真实世界编译器设计中,这些理论如何与工程实践进行权衡和妥协。比如,它对LALR(1)推导过程的细致剖析,让我对栈操作的理解提升到了一个新的高度。书中的图表绘制得极为清晰,特别是那些状态转移图,简直就是艺术品,帮助我瞬间理清了复杂的跳转逻辑。读完后,我立即着手优化了手头项目中的一个解析模块,效果立竿见影,这证明了书本知识的强大实用性。

评分 评分 评分 评分 评分相关图书

本站所有内容均为互联网搜索引擎提供的公开搜索信息,本站不存储任何数据与内容,任何内容与数据均与本站无关,如有需要请联系相关搜索引擎包括但不限于百度,google,bing,sogou 等

© 2026 book.quotespace.org All Rights Reserved. 小美书屋 版权所有