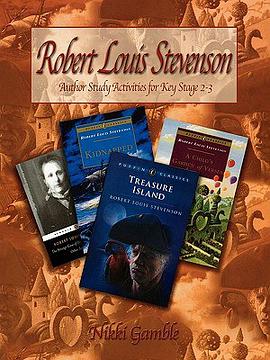

具体描述

作者简介

目录信息

读后感

评分

评分

评分

评分

用户评价

说实话,我最初选择这本书,很大程度上是因为被它的副标题——“考点详解”所吸引。我之前用过几本市面上常见的词汇书,很多都只是简单地给出中文释义和几个例句,但对于为什么这个词会成为考点,以及出题人可能的陷阱在哪里,却语焉不详。这本书在这方面做得极为出色。它不是那种“水”篇幅的词汇大全,而是真正做到了“精炼”和“深度”。每一个核心词汇后面,都会紧跟着一个“考点透视”的小栏目,里面会细致分析该词在不同语境下的细微差别。比如,某个动词的及物和不及物用法差异,或者某个形容词在褒义和贬义上的切换点,这些都是真正在考场上能决定成败的关键细节。我印象最深的是关于那些“形近词辨析”的章节,作者用流程图和对比表格的方式,把几个长得几乎一模一样的词放在一起,从词根、词缀入手进行拆解,直到你彻底弄清楚它们之间的界限。这种深入到“骨髓”的讲解方式,极大地提升了我对词汇的掌握深度,不再是死记硬背,而是真正理解和运用了。

评分我个人对这本书的“系统性”评价非常高,尤其是在词汇的组织逻辑上。很多词汇书是按字母顺序排列,或者按主题简单堆砌,但这本书似乎是基于历年真题中词汇的“关联性”和“重要性”进行重新编排的。它将那些经常同时出现在同一篇文章或同一类题型中的词汇放在一起进行对比学习,形成了一个个微型的知识网络。比如,一组描述“变化趋势”的动词和一组描述“经济衰退”的形容词,它们会被归类在同一个模块下,通过对比学习,我发现记忆效率大大提高了,因为大脑更容易将相关信息进行集群化处理。此外,书中对于一些高频的“短语动词”(phrasal verbs)的处理也极为细致,它不仅解释了短语的整体含义,还单独分析了其后置介词或副词对意义的影响,这在阅读中尤其关键,因为短语动词往往是阅读理解中的“拦路虎”。可以说,这本书提供了一个结构严谨的“知识地图”,引领我在庞大的词汇海洋中,有条不紊地攻克最核心的堡垒。

评分作为一名已经工作多年的职场人士,我的学习时间极其碎片化,通勤路上和午休时间是我唯一的学习时段。因此,我对教材的“便携性和即时反馈性”要求很高。这本书虽然内容详实,但拿到手上却没有想象中那么笨重,纸张质量非常好,不易洇墨,即使用普通中性笔做笔记也很清晰。更让我惊喜的是,它在每一个单元的末尾都设置了“模拟自测”环节,这些测试题的设计思路非常贴合真实的职称考试风格,尤其是那种需要根据上下文选择最合适词汇的完形填空题型,模拟得惟妙惟肖。我通常会利用午休时间快速过一遍前一晚学过的词汇,然后马上做后面的自测题。通过这种即时检验,我可以马上发现自己记忆的盲区和理解上的偏差,避免了等到周末才进行大规模回顾所带来的效率低下问题。这种“学——测——纠正”的闭环设计,极大地提高了我的学习效率,让我感觉每一点投入都有了即时且清晰的回报。

评分这本书的封面设计得非常朴实,以白色为底,配上深蓝色的字体,给人一种严肃而专业的印象,这很符合它“考试用书”的定位。我是在备考职称英语的综合类考试时,经朋友推荐购入的。拿到手后,首先吸引我的是它厚实的质感,感觉内容量一定很扎实。翻开目录,章节划分得非常清晰,涵盖了历年考试中出现频率最高的词汇群,并且很贴心地对每个词汇都做了详细的词源分析和用法辨析,这对于我这种记性不太好、容易混淆近义词的考生来说,简直是福音。尤其是那些固定搭配和易错的介词使用,都有专门的版块进行归纳总结。我特别欣赏的是,它不仅仅是罗列单词,而是将词汇放在了具体的语境中进行讲解,例如,它会列举出这个词在科技、经济、社会文化等不同领域中的常用搭配,这让学习过程不再枯燥,更容易理解词汇背后的实际应用场景。另外,书的排版也很有讲究,重点词汇用粗体突出显示,例句和释义之间的间距适中,长时间阅读也不会感到眼睛疲劳。总的来说,这本书的物理形态和内在结构都透露出一种精心打磨的专业态度,让人一上手就有信心去攻克那些令人头疼的词汇难关。

评分这本书的“人文”部分,可以说是它区别于其他纯粹应试词汇书的亮点所在。我注意到,在讲解一些与社会现象、哲学思辨相关的词汇时,作者并没有止步于基础释义,而是加入了对这些词汇在西方文化或历史背景下的深层含义的探讨。这对于我准备综合类考试来说至关重要,因为综合类的阅读理解往往涉及对文章深层立意的把握,单纯的词汇量堆砌是不够的。例如,书中对“epistemology”(认识论)这个词的讲解,不仅仅是给出定义,还简单勾勒了其在哲学史上的演变,虽然篇幅很短,但足以在阅读相关文章时,帮助我迅速定位作者的思维框架。这种兼顾应试技巧和知识广度的编排,让我感觉自己不仅仅是在准备一场考试,更是在进行一次知识体系的补充和拓宽。它让学习过程变得更有“意义”,不再是机械地为了应付考试而背诵一堆无生命的符号。

评分 评分 评分 评分 评分相关图书

本站所有内容均为互联网搜索引擎提供的公开搜索信息,本站不存储任何数据与内容,任何内容与数据均与本站无关,如有需要请联系相关搜索引擎包括但不限于百度,google,bing,sogou 等

© 2026 book.quotespace.org All Rights Reserved. 小美书屋 版权所有